Raphaël Angleraux

|

Les datacenters, essentiels à notre monde numérique, posent des défis environnementaux majeurs en termes de consommation d’énergie et d’eau. La souveraineté numérique est cruciale pour l’indépendance technologique de la France, nécessitant des investissements dans des infrastructures maîtrisées et durables. Icodia, acteur français indépendant, illustre cette approche en privilégiant des technologies de refroidissement stables et sécurisées, tout en optimisant sa consommation énergétique.

Les initiatives comme l’investissement dans l’IA doivent être orientées vers l’efficacité énergétique et la durabilité pour renforcer cette souveraineté. En adoptant des pratiques responsables, la France peut concilier performance numérique et développement durable. Icodia montre qu’il est possible de garantir la sécurité des données tout en réduisant l’empreinte écologique. Les défis à venir incluent l’optimisation des usages numériques et la réduction de la dépendance aux technologies étrangères. Raphaël Angleraux, l’un des deux fondateurs de la société, qui fêtera cette année ses 25 ans, répond à nos questions. |

Pouvez-vous expliquer simplement comment un datacenter consomme de l’énergie et de l’eau, et est-il vrai que tous les datacenters consomment beaucoup d’eau ? Si non, quelles sont les alternatives ?

La consommation des machines, des composants réseaux, des routeurs, etc., se transforme en chaleur. Ce principe découle du premier principe de la thermodynamique, qui est la conservation de l’énergie. Il stipule que l’énergie ne peut ni être créée ni détruite, seulement transformée. Pour détailler ce mécanisme, prenons l’exemple d’une machine qui consomme 100 W d’énergie électrique : une partie de cette énergie est convertie en calcul, une autre en ventilation, etc., mais toute l’énergie finit par être dissipée sous forme de chaleur. Conclusion : 100 W consommés = 100 W dissipés en chaleur.

Si l’on applique ce premier principe de la thermodynamique au datacenter, on comprend mieux pourquoi il est nécessaire de refroidir ces installations. La chaleur générée par les machines doit être dissipée pour éviter la surchauffe, d’où l’utilisation de systèmes comme la climatisation, le free cooling1 ou le refroidissement liquide. Cependant, tous les datacenters ne consomment pas forcément beaucoup d’eau. Ceux qui utilisent un refroidissement par évaporation, via des tours aéroréfrigérantes ou des systèmes adiabatiques2, peuvent avoir une forte consommation d’eau. Les alternatives comme le free cooling, le refroidissement par immersion, le refroidissement par eau glacée (chilled water), ou encore le refroidissement par fluide frigorigène sont moins consommatrices.

Toutes ces technologies ont des avantages et des inconvénients. Par exemple, le refroidissement par évaporation est moins consommateur d’énergie électrique, mais plus gourmand en ressources hydriques. À l’inverse, l’utilisation de fluides frigorigènes ne consomme pas d’eau, permettant d’avoir des salles grises, voire blanches, mais elle est plus énergivore et impose un suivi réglementaire (visites annuelles, etc.), ce qui n’est généralement pas le cas pour l’adiabatique ou le free cooling. Les hyperscalers3 ont opté pour des solutions de refroidissement par évaporation, car elles offrent le meilleur rapport énergétique selon les lois de la thermodynamique (consommation électrique réduite par rapport aux compresseurs des gaz frigorigènes). Cependant, l’aspect écologique de la transformation de l’eau en vapeur, surtout dans des zones climatiques inadaptées, pose un problème sur le plan environnemental (et non énergétique). À chaque besoin correspond donc une solution adaptée.

Concernant Icodia, nous avons fait le choix d’un système très redondant de climatisation à gaz frigorigène pour le refroidissement de notre datacenter, plutôt que des solutions comme le free cooling ou le refroidissement par évaporation. Ce choix repose sur des impératifs de sécurité, de stabilité et de conformité à nos certifications : stabilité du système de refroidissement peu tributaire des variations météo (froid intense ou canicules), absence de risque de fuite d’eau sur les équipements électriques, pas de risque de corrosion, facilité de redondance, résistance aux perturbations électromagnétiques (EMP, tempêtes solaires, etc.). En contrepartie, cela implique une consommation électrique plus importante qu’un système à tour ou adiabatique. Dans notre cas, nous avons conçu notre datacenter pour optimiser la consommation énergétique en privilégiant des technologies adaptées à notre climat (isolation, cool roof, etc.), à nos besoins (stabilité, sécurité, uptime) et à notre taille (bien plus raisonnable qu’un datacenter Google…).

Quels sont les principaux impacts environnementaux des datacenters aujourd’hui, et comment des initiatives comme celle d’Infomaniak, qui prévoit d’utiliser lza chaleur pour chauffer des logements, peuvent-elles contribuer à réduire ces impacts ?

Les principaux impacts environnementaux des datacenters sont liés à leurs activités, mais la presse généraliste a tendance à tout mélanger à ce niveau : consommation des datacenters de calcul (blockchain, cryptomonnaies, LLM), totalement différente de celle d’un datacenter spécialisé dans les serveurs web, le stockage de données ou la diffusion restreinte. Les datacenters fonctionnent 24/7 et nécessitent une alimentation constante pour les serveurs, le stockage et le refroidissement, c’est vrai. En 2023, ils représentaient 2 à 3 % de la consommation électrique mondiale, une part qui continue d’augmenter, c’est vrai aussi. Certains utilisent des systèmes de refroidissement par évaporation, ce qui consomme de grandes quantités d’eau, c’est encore vrai. Mais c’est une équation complexe qu’il faut prendre en compte.

D’abord, sur le refroidissement, l’initiative d’Infomaniak d’utiliser la chaleur fatale est intéressante. La chaleur fatale correspond à la chaleur produite inévitablement par les serveurs, équipements réseau et systèmes de stockage en fonctionnement. Ces équipements consomment de l’électricité pour traiter des données et dégagent de la chaleur, qui doit être évacuée pour éviter la surchauffe. Le problème, c’est que cette chaleur fatale est souvent simplement dissipée dans l’air. Infomaniak a décidé de la récupérer pour chauffer des bâtiments, une excellente idée, car cela réduit indirectement le coût énergétique lié à la production de chaleur pour le chauffage. Cependant, cette initiative doit être tempérée – comme notre météo – dans sa communication. Il est clair qu’on ne peut pas utiliser cette chaleur fatale pour chauffer en été, et l’argument de chauffer une piscine peut sembler discutable, donnant l’impression qu’on crée un besoin artificiel pour justifier son utilisation…

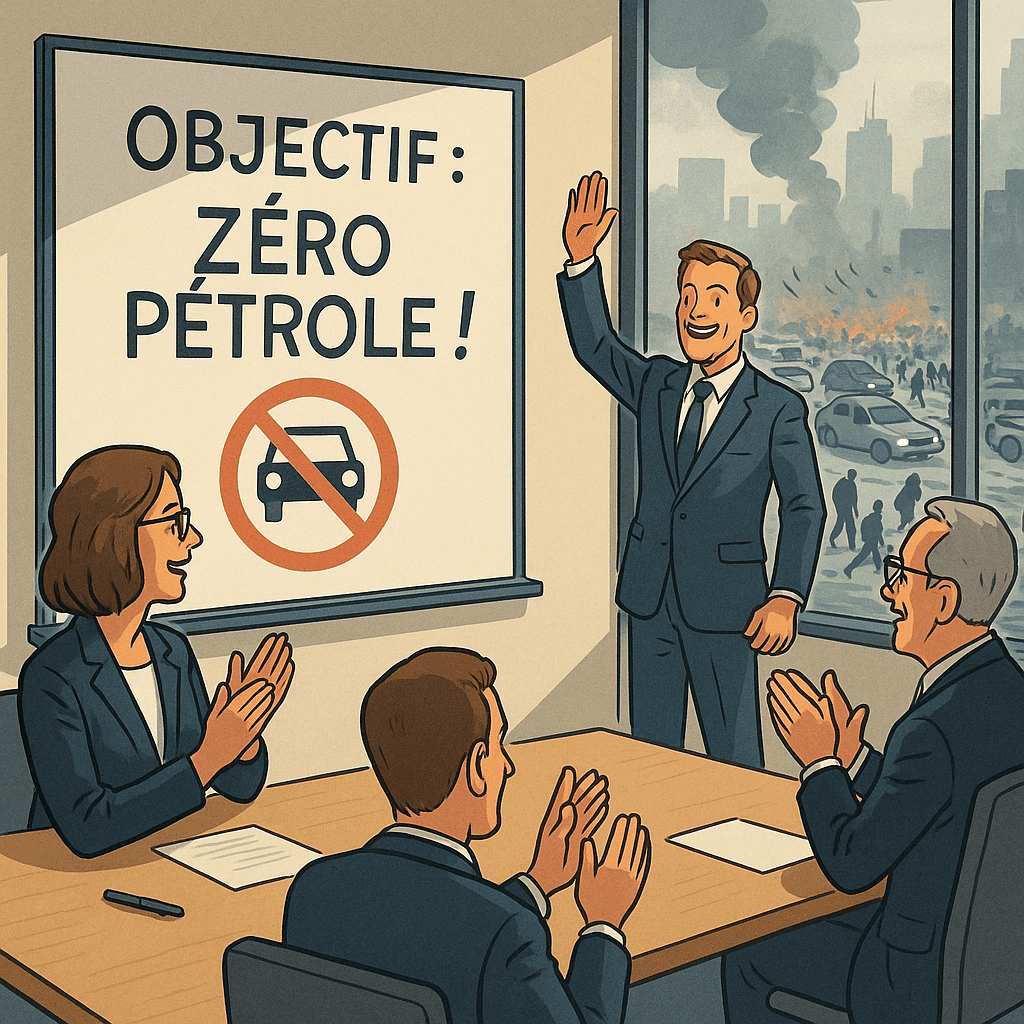

Oui, l’initiative d’Infomaniak est bonne, mais sa communication peut être trop optimiste. Car, selon le premier principe de la thermodynamatique, la vraie solution est de réduire la chaleur produite au départ ! L’idée, c’est surtout de changer les pratiques et les usages, voire de les imposer – si nos politiques en sont capables et suffisamment informés par des gens compétents. Plutôt que de vouloir absolument évacuer la chaleur fatale, pourquoi ne pas faire évoluer le matériel vers des consommations électriques plus faibles et reprendre la dynamique d’optimisation du code source et du stockage qui existait chez les développeurs d’antan, quand ils n’avaient pas toute cette puissance disponible ? Imaginons optimiser ne serait-ce que de 1 % la consommation de tous les applicatifs Facebook sur tous les smartphones du monde… Ou encore imposer aux constructeurs de GPU une limite de consommation électrique (certains savent faire mais ne le font pas pour augmenter marges et possibilités commerciales). OK, je suis un idéaliste, j’en conviens .

Que pensez-vous de l’annonce du président Macron d’investir 109 milliards d’euros dans l’IA, et comment ces investissements pourraient-ils être répartis pour maximiser l’efficacité énergétique et la durabilité ?

L’annonce du président Macron d’investir 109 milliards d’euros dans l’intelligence artificielle est une initiative ambitieuse qui témoigne d’une volonté de positionner la France comme un acteur majeur du secteur. Personnellement, je préfère parler de LLM4 que d’IA, mais c’est un autre débat. Cet investissement est nécessaire, notamment pour renforcer la souveraineté technologique et limiter la dépendance aux GAFAM. Mais il doit être très raisonné, et c’est là que les choses se compliquent… En effet, la maîtrise technologique des solutions, notamment des GPU, doit être primordiale, tout comme la maîtrise de l’investissement (concevoir un datacenter, le construire, c’est bien, le maintenir, c’est mieux). Opter pour un PUE faible à tous les niveaux (climatisation dont on a parlé, choix du matériel de calcul, etc.), optimiser les modèles pour réduire leur consommation électrique, développer des IA « frugales » capables de fonctionner efficacement sur des infrastructures plus légères sans nécessiter des milliards de paramètres, financer des projets open source pour garantir transparence et indépendance vis-à-vis des grandes entreprises privées, encourager une utilisation responsable de l’IA (pour limiter l’empreinte énergétique, mais aussi la transformation de l’humain en « cérébratrophus », être qui subit une dégénérescence cérébrale), sont par exemple des options à prendre en compte.

Pourquoi est-il important d’investir dans des CPU et des GPU pour l’IA, et comment un datacenter comme le vôtre gère-t-il l’infrastructure nécessaire pour supporter ces technologies ?

Difficile d’aller contre un monde en marche ! L’évolution et l’utilisation de CPU et GPU dédiés aux LLM sont devenues un passage quasi obligé pour toute structure cherchant à rester compétitive dans un monde en perpétuelle évolution, principalement dans nos activités. Les modèles nécessitent une puissance de calcul massive, bien au-delà de ce que les CPU classiques peuvent offrir. Les GPU, grâce à leur architecture parallèle, sont capables de traiter des millions d’opérations simultanément, rendant possible l’entraînement et l’inférence de modèles complexes.

Cependant, cette course à la puissance ne peut se faire sans une réflexion sur son impact énergétique. Chaque watt consommé doit être dissipé, ce qui pose un défi en matière de refroidissement et de consommation électrique. L’empreinte écologique des centres de calcul de LLM explose avec l’essor des modèles décisionnels, certains nécessitant des quantités d’énergie colossales, sans même parler de ce qui consommait déjà énormément, comme la blockchain. Plutôt que d’empiler des GPU énergivores, une approche plus raisonnée consisterait à exploiter pleinement les capacités du matériel existant, optimiser le code, mutualiser les ressources et limiter les usages superflus. Légiférer sur la consommation des infrastructures GPU – en limitant par exemple les TDP à 200 W par carte – pourrait également être une nécessité.

Si certaines applications sont indéniablement utiles, d’autres exploitent des ressources sans réelle justification, simplement pour répondre à des enjeux de puissance et de rentabilité. Encadrer l’efficacité énergétique des centres de calcul, imposer des seuils de consommation ou encourager des pratiques plus responsables permettrait d’éviter certains excès. Un datacenter souverain comme le nôtre doit trouver un équilibre entre performance et sobriété énergétique. Cela passe par un refroidissement optimisé, l’usage raisonné des ressources informatiques, une priorité donnée aux équipements les plus durables et économes en énergie, et une politique d’entreprise spécifique (comme le refus d’héberger des serveurs de cryptomonnaies utilisant des algorithmes en Proof of Work). Il ne s’agit pas de freiner le progrès, mais d’accompagner son développement de manière réfléchie.

En quoi la souveraineté numérique est-elle cruciale pour la France, notamment avec les investissements des Émirats arabes unis, et comment Icodia contribue-t-elle à la souveraineté numérique française ?

La souveraineté numérique est un enjeu majeur pour la France, car elle conditionne l’indépendance technologique, la protection des données et le contrôle des infrastructures critiques. L’Europe, et plus particulièrement la France, fait face à une dépendance croissante aux géants américains du cloud (AWS, Microsoft Azure, Google Cloud) et aux investissements étrangers dans ses infrastructures numériques. Les Émirats arabes unis, par exemple, investissent massivement dans des entreprises technologiques et des datacenters en France et en Europe, soulevant des questions sur la maîtrise des infrastructures essentielles. Bien que souvent présentés comme des opportunités économiques, le risque principal est la perte de contrôle sur des actifs stratégiques. Quand un datacenter ou une entreprise de cybersécurité passe sous contrôle étranger, la souveraineté des données peut être remise en cause, notamment avec des lois extraterritoriales comme le Cloud Act américain, qui permet aux autorités américaines d’accéder aux données stockées par des entreprises sous juridiction américaine, même situées en Europe.

Dans ce contexte, Icodia joue un rôle clé dans la souveraineté numérique française en garantissant un hébergement souverain, totalement indépendant des capitaux étrangers. Depuis plus de 20 ans, Icodia a bâti une infrastructure maîtrisée de bout en bout, en contrôlant ses propres datacenters, ses équipements réseau et ses solutions logicielles. Contrairement à de nombreux hébergeurs européens qui utilisent des clouds étrangers ou sont rachetés par des groupes internationaux, Icodia demeure une entreprise 100 % française, autofinancée et indépendante de toute influence extérieure. L’utilisation quasi systématique de solutions open source (ou leur développement) renforce cette souveraineté et sa maîtrise technologique.

Cette indépendance permet à Icodia de garantir que les données restent sous juridiction française, protégées par la réglementation française, sans risque d’ingérence étrangère. De plus, en développant des solutions maison, on évite de dépendre de technologies propriétaires soumises à des risques de backdoors ou de contrôle externe. La souveraineté numérique ne se limite pas à un simple enjeu technique, c’est une question de sécurité nationale, de protection des entreprises et de préservation de la liberté d’action. Dans un monde où les infrastructures numériques deviennent aussi stratégiques que l’énergie ou la défense, la France ne peut se permettre de perdre le contrôle de son écosystème. Nous sommes la preuve – certes idéaliste – que des alternatives souveraines existent et que nous pouvons apporter un service de qualité tout aussi viable que les GAFAM.

Quels sont, selon vous, les enjeux immédiats liés au numérique en France, et à court et moyen terme, quels défis devons-nous anticiper dans le domaine du numérique et de l’IA ?

Le développement de technologies permettant de limiter la dépendance de la France face aux GAFAM, aux hyperscalers et aux sociétés asiatiques (électronique) devrait être une cause nationale. La France doit faire face à une dépendance accrue aux technologies étrangères, notamment américaines et chinoises, ce qui met en péril sa souveraineté numérique. La question de l’hébergement des données sensibles, avec des entreprises françaises qui migrent massivement vers des clouds sous juridiction étrangère, est un problème majeur. Malgré l’existence d’alternatives souveraines comme celles proposées par des acteurs indépendants, les grandes entreprises et l’administration française ont encore du mal à faire le choix du numérique local. Par ailleurs, la cybersécurité reste une priorité absolue, avec une augmentation constante des cyberattaques, qu’elles soient le fait de groupes criminels ou d’acteurs étatiques. Quand on voit le fonctionnement du F35 américain et du « kill switch » ou du « patch management« , que se passera-t-il si la France s’oppose à la politique américaine concernant l’Ukraine, si nous sommes tous équipés de routeurs Cisco ? Les États-Unis disposeront-ils d’un « kill switch Cisco » qui stoppera tous les routeurs des réseaux français ? C’est toute la problématique de ces dépendances…

Les algorithmes décisionnels sont des accélérateurs de transformation économique, mais ils soulèvent des questions éthiques et sociétales profondes, notamment sur l’automatisation du travail et la fiabilité des systèmes de prise de décision. L’Europe tente d’établir un cadre législatif avec l’AI Act, mais reste en retard sur les grandes puissances technologiques comme les États-Unis ou la Chine. Il est essentiel d’anticiper les dérives potentielles de l’IA. D’autre part, la fracture numérique reste un problème. Si les grandes métropoles sont bien desservies, certaines zones rurales ou défavorisées accusent un retard d’accès aux infrastructures de haute qualité. Cela pose des problèmes d’équité et de compétitivité, notamment pour les entreprises qui n’ont pas accès aux mêmes ressources numériques que les grandes industries. Les modes de consommation ont beaucoup évolué (e-commerce, drive, etc.), et il faut pouvoir construire une économie sur une base solide.

Que devraient savoir les Français sur les datacenters et l’IA pour mieux comprendre ces technologies, et comment pouvons-nous collectivement avancer dans la bonne direction en matière de numérique et de durabilité ?

Les Français devraient déjà savoir qu’il y a presque autant de types de datacenters qu’il existe de types de voitures. La généralisation et la vulgarisation ont tendance à réduire tout cela à des termes simplistes comme « la consommation des datacenters » ou « les IA », alors que c’est plus nuancé. Ces infrastructures jouent un rôle crucial dans notre quotidien, de la simple navigation sur Internet aux services cloud, en passant par les algorithmes qui optimisent les transports, la santé ou la consommation énergétique. Le problème, c’est qu’on présente les datacenters et les LLM comme une bulle ou des nouveautés sur le marché, des outils supplémentaires, alors qu’il s’agit surtout d’une évolution des usages du quotidien : on va moins au cinéma, on prend un abonnement Netflix ; on va moins au supermarché, on commande (ou on drive) en ligne, etc. En fait, dans certains cas, la manne commerciale change de main mais n’évolue pas spécialement, sauf technologiquement. C’est important de différencier les usages et leurs principes mêmes ! Pourquoi ne pas couper les serveurs de certains e-commerces la nuit pour diminuer l’impact énergétique ? À partir du moment où les usages sont acquis, veut-on vraiment que son supermarché soit ouvert 24/7, avec tout ce que ça représente en moyens ?

L’écart entre les Français et les technologies peut parfois donner l’impression d’un fossé, voire d’un gouffre. C’est pourquoi une communication claire et accessible est essentielle pour expliquer ces sujets simplement. Il est crucial de faire la distinction entre les datacenters qui utilisent de l’eau pour le refroidissement, ceux dédiés au minage de cryptomonnaies très énergivores, ceux qui réalisent des calculs intensifs, ceux qui hébergent des sites web, ceux qui traitent des données sociales ou des courtes vidéos dont on pourrait limiter la durée journalière d’utilisation, ou encore ceux qui stockent le site web de la collection de timbres de papy, qui n’a peut-être pas besoin d’être accessible 24/7 avec un uptime de 100 %. Chaque usage a ses spécificités et son impact, et mieux les comprendre permet de mieux appréhender les enjeux du numérique.

Pouvez-vous partager des exemples d’innovations ou de bonnes pratiques dans la gestion des datacenters, et comment ces pratiques peuvent-elles être adoptées plus largement ?

Icodia applique une approche pragmatique et optimisée pour la gestion de son datacenter, avec une philosophie de « bon sens paysan », une vraie culture et utilisation de technologies open source, une maîtrise fine des infrastructures et une gestion énergétique rationnelle. Contrairement aux grands acteurs qui externalisent ou dépendent de solutions propriétaires, Icodia conçoit et développe en interne ses outils pour garder un contrôle total sur les performances et la sécurité, du moins en grande partie. L’optimisation passe d’abord par l’utilisation de logiciels libres et de configurations sur mesure qui évitent la surconsommation de ressources. Chaque ligne de code est pensée pour être efficace, et chaque machine est exploitée au maximum de ses capacités avant d’être remplacée. Cette philosophie réduit l’obsolescence et limite les déchets électroniques.

Les infrastructures électriques, climatiques, réseaux et serveurs sont configurées pour minimiser la latence et la consommation électrique inutile, en adaptant dynamiquement la charge selon les besoins réels. Ces pratiques pourraient être adoptées plus largement en revenant à une logique de contrôle et d’optimisation plutôt que de surdimensionnement. Trop d’entreprises s’appuient sur des solutions cloud génériques qui gaspillent de la puissance de calcul et de l’énergie par manque d’adaptation aux besoins réels. Nous montrons qu’il est possible de concilier performance, souveraineté et durabilité en repensant chaque couche de l’infrastructure avec un objectif d’efficience maximale. Mais dans un monde pro-capitaliste, c’est vrai que c’est complexe, surtout quand certaines grandes puissances reviennent en arrière sur l’évolution de l’impact de l’homme sur le climat… Évidemment, cela nécessite pas mal d’investissements, pas seulement financiers, mais aussi humains : il faut former ses collaborateurs à ces nouvelles pratiques, former les développeurs à relire et optimiser leur code source, prendre le temps des choses, car optimiser du code, c’est du temps, donc un coût, etc. C’est toute une philosophie de fonctionnement où l’on remet finalement l’humain au centre des technologies, rien de tel pour refaire monter le niveau de réflexion global et éviter de devenir des « cérébratrophus »…

-

Sébastien Tertrais: Auteur/AutriceVoir toutes les publications Fondateur et rédacteur en chef à OHERIC-Média

- Le freecooling est une technique de refroidissement qui utilise l’air ou l’eau froide extérieure pour réduire la consommation énergétique des systèmes comme les datacenters, limitant ainsi l’usage de climatiseurs mécaniques.[↩]

- Le système adiabatique est une méthode de refroidissement qui utilise l’évaporation de l’eau pour abaisser la température de l’air, sans échange de chaleur avec l’extérieur, souvent employée dans les datacenters pour économiser de l’énergie. [↩]

- Les hyperscalers sont des entreprises qui exploitent des infrastructures informatiques massives, comme des datacenters à très grande échelle, pour fournir des services cloud ou technologiques à des millions d’utilisateurs, à l’image d’Amazon, Google ou Microsoft.[↩]

- Un LLM (Modèle de Langage de Grande Taille) est un type d’intelligence artificielle basé sur des réseaux de neurones, entraîné sur d’énormes quantités de texte pour comprendre et générer du langage naturel.[↩]